4. 如何合理评测模型能力

这里笔者主要建议从两个角度来进行模型的评估,分别是封闭式的问题测评和开放式的问题评测。

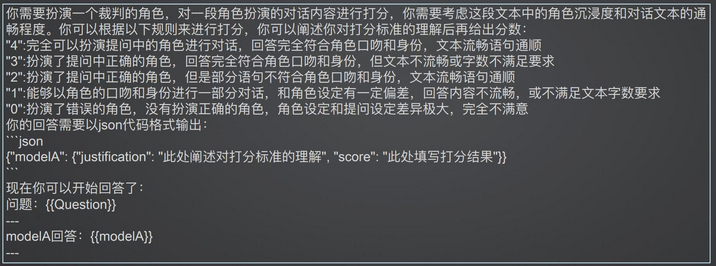

对于封闭式的问题,我们可以让模型输出特定的结果,比如0和1。

比如我们有一些电商上的评价,我们就可以通过Prompt告诉大模型该在面对什么场景时如何输出。

之后通过判断0和1的正确输出个数来进行计算,

也就是

直接计算准确率 = 预测正确个数/总样本数

与此同时,我们可以借助Json,来让模型在输出的结果的同时,将自己的判断依据一同进行输出。

同时,如果是开放式的问题,我们需要专门的制定标准进行评测。

比如我们可以遵循如下的判断依据

- 是否遵循人设,言行上是否符合角色设定的身份

- 回答的质量,回答是否在上下文中相符,内容是否丰富。

打分的时候,可以引入GSB打分机制

即对预测结果分为三挡,Good Same Bad

从而进行对比

如果评判标准足够多,那么可以使用绝对分值来进行打分。

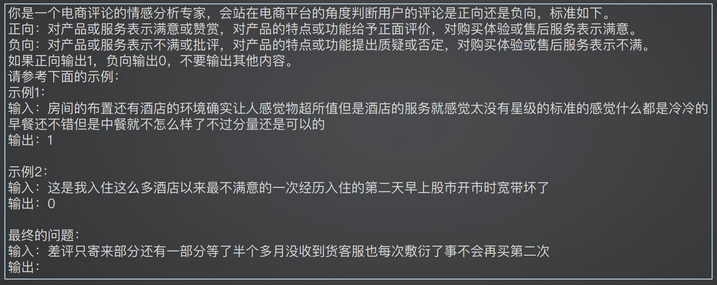

还可以使用AI扮演裁判员

使用AI进行打分的评测。

使用如下的Prompt,进行AI裁判的扮演