1.初入Dify

本次我尝试使用Ollama 进行Deepseek的运行,并将其作为大模型暴露给Dify使用,从而实现模型编排

首先是Ollama的运行,本次采用本地直接运行Ollama,因此是Windows系统

直接在官网下载

之后安装完成

通过window powershell进行使用

命令行输入

ollama run deepseek-r1:8b

即可运行deepseek对应版本

同时进行Dify的安装

本次采用源码进行本地的启动

首先是进行源码的clone

git clone https://github.com/langgenius/dify.git

进行example的准备

执行cd dify/docker

将.env.example 复制为.env

执行

docker compose up -d

之后进入本地环境进行初始化

# 本地环境

http://localhost/install

由于compose默认运行在80端口上

所以直接访问http://localhost即可

如果需要关闭,直接运行docker compose down 即可

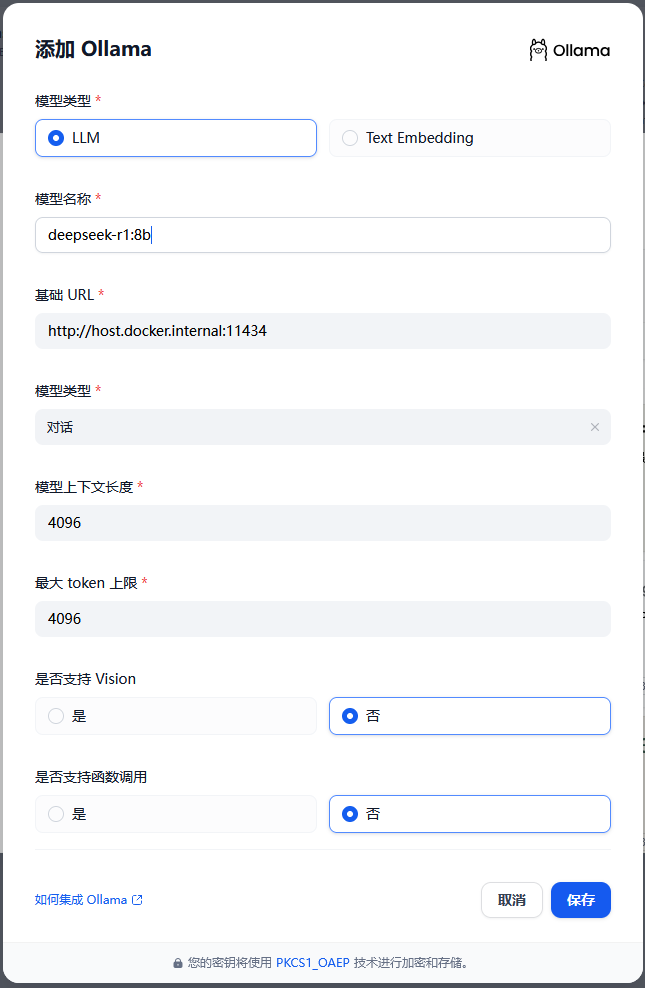

之后将ollama中运行的模型暴露给Dify

通过设置中的配置大模型即可

设置供应商为ollama

然后填入路径

http://host.docker.internal:11434

设置模型为对应模型

deepseek-r1:8b即可

如此就可以使用ollama中运行的大模型作为dify编排的大模型工具